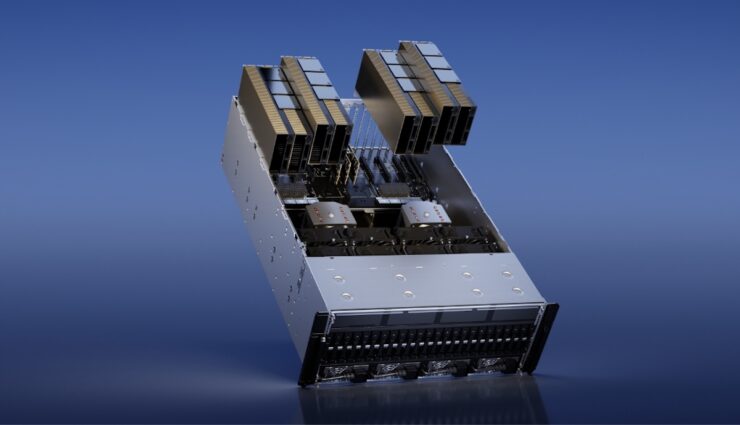

Wer dachte, Computer-Prozessoren müssten irgendwann nicht mehr immer noch leistungsfähiger werden, hat die Rechnung ohne künstliche Intelligenz gemacht: Nvidia als der wichtigste Anbieter in diesem Bereich kann sich vor Nachfrage nach seinen neuesten H100-Chips (s. Foto) kaum retten. Allein Tesla hat 10.000 dieser für KI-Aufgaben optimierten Grafik-Prozessoren gekauft und nach eigenen Angaben am Montag als Cluster in Betrieb genommen – bevor der vollständig selbst entwickelte Dojo-Computer folgen soll.

Neuer Tesla-Supercomputer gestartet

Schon Mitte 2021 betrieb Tesla nach Angaben seines damaligen KI-Chefs Andrej Karpathy den fünftschnellsten Superrechner der Welt, bestehend aus 5760 Nvidia-GPUs des zu der Zeit modernsten Typs A100. Bei einer Präsentation dazu kündigte er als nächsten Schritt bereits „Dojo“ an, der dann im August näher erläutert wurde: ein Tesla-Supercomputer mit selbst entwickelten Chips und eigener Architektur speziell für effizientes Video-Training künstlicher Autopilot-Intelligenz.

Für Dojo werde Tesla bis Ende nächsten Jahres mehr als 1 Milliarde Dollar ausgeben, sagte CEO Elon Musk Mitte Juli in einer Telefon-Konferenz. Man verwende aber auch viel Nvidia-Hardware und kaufe so viel davon, wie zu bekommen sei. Und das war offenbar durchaus eine Menge: An diesem Montag gehe ein neuer KI-Cluster aus 10.000-mal H100 in Betrieb, kündigte am Wochenende Tim Zaman an, früher bei Nvidia und heute bei Tesla und X zuständig für Infrastruktur.

Tesla AI 10k H100 cluster, go live monday.

Due to real-world video training, we may have the largest training datasets in the world, hot tier cache capacity beyond 200PB – orders of magnitudes more than LLMs.

Join us!https://t.co/F4A0Qb0CXG— Tim Zaman (@tim_zaman) August 26, 2023

Aus 5760 und nach einer Zwischenmeldung von Mitte vergangenen Jahres 7360 A100-Prozessoren bei Tesla sind inzwischen also 10.000 des neueren Typs H100 geworden oder zu ihnen hinzugekommen. Wie CEO Musk dazu schrieb, bestand der bisherige Tesla-Cluster zuletzt sogar aus rund 16.000-mal A100. Der Nachfolger sei nach den eigenen Erfahrungen dreimal so schnell. Wenn der Supercomputer aus den neuen H100s läuft, hätte sich die Rechenleistung bei Tesla also in etwa verdoppelt. Ob das einen Platz weit oben in der weltweiten Supercomputer-Rangliste bedeuten würde, erwähnte Zaman nicht. Er schrieb aber von einer „hot cache“-Kapazität von mehr als 200 Petabyte, was um Größenordnungen mehr sei als bei so genannten LLMs.

Training compute should soon not be so much of a limiting factor.

Very difficult bringing the 10k H100 cluster online btw.

Similar experience to bringing our now 16k A100 cluster online. Uptime & performance are low at first, then improve with lots of work by Tesla & Nvidia.

— Elon Musk (@elonmusk) August 31, 2023

Diese riesigen Sprachmodelle wie Chat-GPT sorgen derzeit für neue KI-Begeisterung wie -Ängste und gehören zu den stärksten Treibern der Nachfrage bei Nvidia. Laut dem Fachblog GPU Utils kostet eine Einheit mit acht H100-GPUs 460.000 Dollar, davon etwa 100.000 Dollar für Service-Leistungen. Selbst wenn Tesla auf dieses Extra verzichten konnte, hätten die 10.000 neuen Nvidia-GPUs also knapp eine halbe Milliarde Dollar oder die Hälfte des von Musk bis Ende 2024 veranschlagten Dojo-Budgets gekostet.

Musk will Dojo und Nvidia nutzen

Diese Investition scheint allerdings zusätzlich zu der in die fertige KI-Hardware geplant zu sein. Tesla werde sowohl Nvidia als auch Dojo nutzen, sagte Musk in der Konferenz im Juli, in der er die Ausgaben von 1 Milliarde Dollar für das eigene System erwähnte. Damit die Autopilot-Software FSD besser fahren lerne als ein Mensch, würden enorme Trainingsressourcen gebraucht, die massenhaft Daten auswerten, erklärte er. Und in einer X-Diskussion über KI bei Google, das ebenfalls eigene Computer dafür baut, wiederholte Musk am Montag, dass Tesla mit Dojo wie Nvidia arbeiten werde.