Vergangene Woche gab Andrej Karpathy, Chef für Künstliche Intelligenz (KI) bei Tesla, bei einer Konferenz einige interessante Einblicke in die Arbeit seines Teams an der neuen Generation der Autopilot-Software FSD (kurz für Full Self-Driving). Aber er verwirrte auch, denn zum einen bezeichnete er einen der Computer, mit denen Tesla seine Beta-Software trainiert, als den wohl fünftschnellsten der Welt. Auf der anderen Seite nannte Karpathy eine Rechenleistung von 1,8 Exaflops – was die Maschine locker zum stärksten Supercomputer überhaupt machen würde. Und was stimmt jetzt?

Eine Frage der Genauigkeit

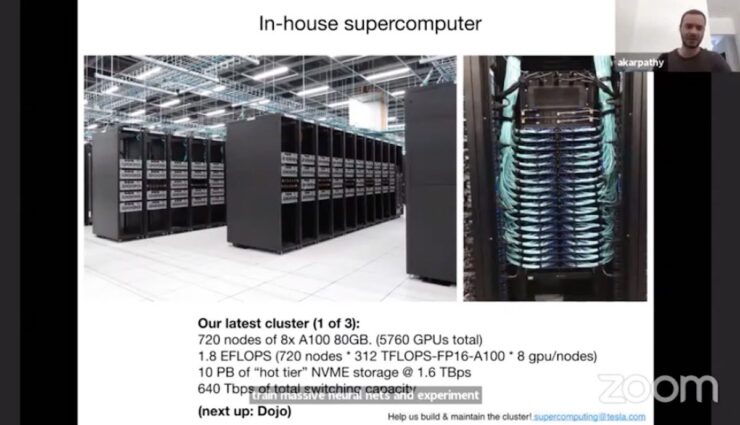

Ein Blick in das Datenblatt des verwendeten Nvidia-Grafikprozessors schafft Klarheit. Tesla verwendet Grafikprozessoren des Typs A100. Jeder davon kommt schon allein auf 312

Billionen Fließkomma-Operationen pro Sekunde, abgekürzt als Teraflops (oder sauberer als Teraflops/s). Und weil Tesla 5760 von diesen Prozessoren nutzt, kommt man auf den Wert von 1,8 Exaflops, den Karpathy nannte.

Doch das ist fast buchstäblich nur die halbe Wahrheit – denn der A100 schafft seine 312 Teraflops nur mit halber Genauigkeit. Die Genauigkeit bezeichnet die Anzahl der Bytes, mit der eine Zahl verarbeitet wird. Je mehr Bytes und damit Stellen die Zahl hat, desto genauer ist die Berechnung und desto langsamer wird relativ gesehen der Prozessor. Supercomputer werden normalerweise mit doppelt so hoher Genauigkeit wie der bei dem Nvidia-Chip verglichen, und dann sieht es für den A100 ganz anders aus: Statt 312 Teraflops schafft er nur noch 19,5 Teraflops. Bei 5760 Stück davon ergeben sich so gut 112 Petaflops, also etwa 0,1 Exaflops.

Damit passt dann auch alles wieder zusammen. Der offiziell leistungsfähigste Supercomputer der Welt heißt Fugaku, steht in Japan und kommt auf 442 Petaflops. Das klingt weniger als die von Teslas KI-Chef Karpathy genannten 1,8 Exaflops, ist es aber wie oben erklärt nicht. Den fünftschnellsten Rechner der Welt wiederum könnte Tesla mit dem vergleichbaren Wert von 112 Petaflops aktuell durchaus schon haben.

Dojo-Infos bei Teslas KI-Tag?

Ebenfalls in dieses Bild passt, dass der nächste Supercomputer, den Tesla-Chef Elon Musk schon Dojo getauft hat, etwa zehnmal so schnell sein soll wie der jetzige – und dann tatsächlich die Exaflops-Grenze überschreiten. Das dürfte das KI-Training der FSD-Software erheblich beschleunigen. In einem Monat „oder so“, wie Elon Musk in dieser Woche twitterte, will Tesla einen KI-Tag veranstalten, um neues Personal zu rekrutieren. Bei dieser Gelegenheit dürfte er auch mehr über den Dojo-Rechner verraten.